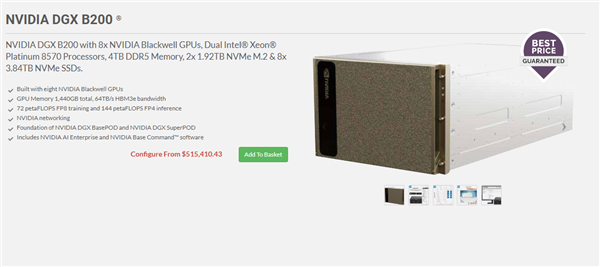

最近、NVIDIAのAIサーバ「DGX B 200」がBroadberryで515,410ドルという価格で発売されました。この発表は、AI業界における技術革新の一環として大きな注目を集めています。新たに導入されたBlackwellアーキテクチャにより、このサーバは業界内で高く評価されています。ジェンセン・ウォンによる賞賛の声も高く、特にマイクロソフトやMetaといった主要なテック企業によって迅速に採用されました。

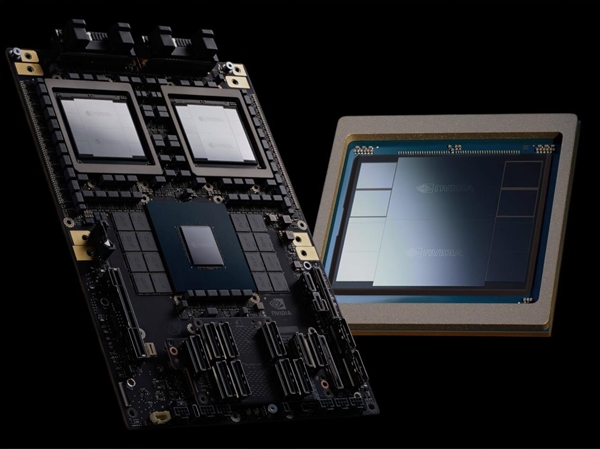

DGX B 200は、8つのB 200 GPUを搭載し、圧倒的な1.4TBのGPUメモリと最大64TB/SのHBM 3 Eメモリを備えています。NVIDIAはこのサーバのトレーニング性能が最大72ペタFLOPS、推論性能が最大144ペタFLOPSであり、従来のモデルと比較してトレーニング性能は3倍、推論性能は15倍向上したと主張しています。

ソフトウェアの面でも、NVIDIAのDGXキットには企業向けに最適化された「NVIDIA AI Enterprise」ソフトウェアが含まれています。ユーザーはこのDGX B 200システムを用いてDGX SuperPodを構築することができ、優れたAIセンターを築くことが可能です。これにより、大規模な開発チームによる多様なタスクの効率的な実行が見込まれます。

明らかに、これはNVIDIAのBlackwell AI製品がオンライン小売市場に初めて登場したことを示しています。OpenAIは最近、ソーシャルメディアを通じてNVIDIAの初のDGX B 200エンジニアリングユニットを受け取ったことを明らかにしています。