NVIDIAは、スーパーコンピューティングカンファレンス「SC 24」において、データセンター製品ラインの拡張を発表し、「GB 200 NVL 4」と「H 200 NVL PCIe GPU」を公開しました。

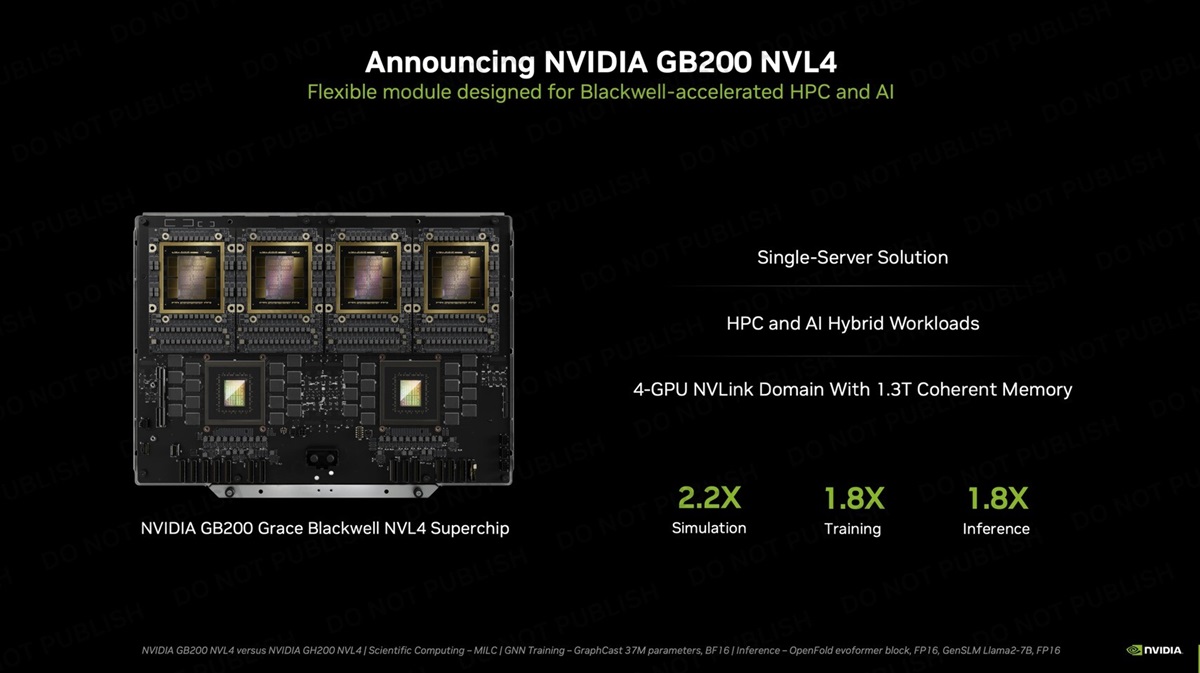

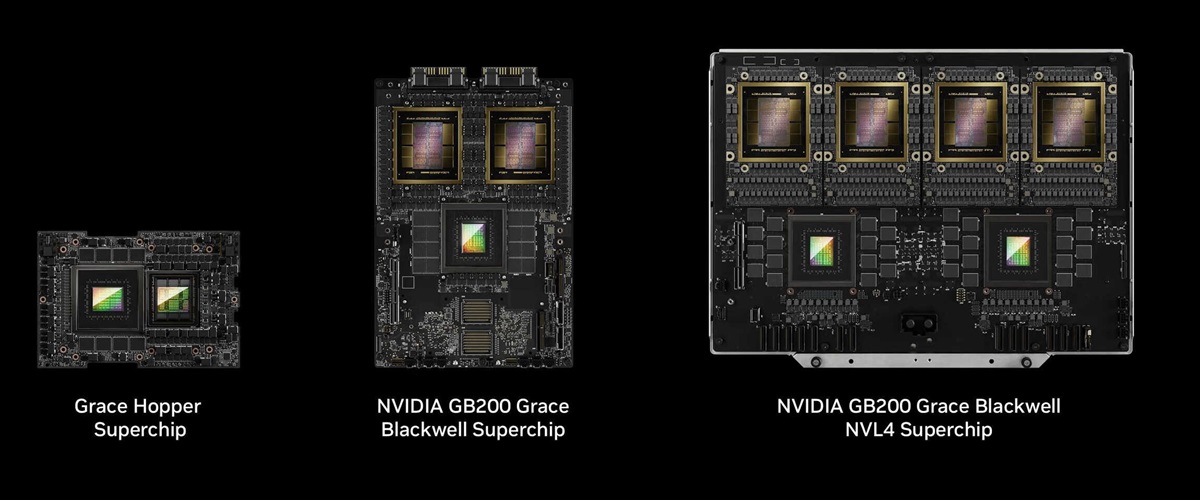

GB 200 NVL 4は、Blackwellアーキテクチャを活かした高度なシングルサーバーソリューションです。このシステムは、4つのBlackwell GPUと2つのGrace CPUを1枚のマザーボードに緻密に統合し、NVLinkインターコネクト技術を駆使して効率的な通信を可能にしています。また、768 GBのHBM3Eと960 GBのLPDDR5Xメモリを備え、32 TB/秒という驚異的なメモリ帯域幅を誇ります。これにより、要求の厳しいAIワークロードでも高いパフォーマンスを発揮する強力なシステムを実現します。

NVIDIAによれば、GB 200 NVL 4はGH 200 NVL 4と比べてシミュレーション性能が2.2倍、AIトレーニング性能が1.8倍、AI推論性能が1.8倍向上しています。このシステムは、5400Wの消費電力を持つエネルギー集約型でありながら、先進的な液体冷却システムを備えて、最適な性能を維持します。大規模コンピューティングの顧客向けにサーバーラックへの展開が予定されています。

NVIDIAのH200 NVL PCIe GPUは、Hopperファミリーに新たに追加された製品です。データセンターを運営する企業向けに設計されており、低消費電力で空冷ラックの設計にうまく対応します。この柔軟性により、多様なAIおよびHPCアプリケーションの効率的な促進が可能です。最近の調査によると、企業用ラックの約70%が20kW以下で動作し、空冷に依存しているため、PCIe GPUの重要性が強調されています。

H200 NVL PCIe GPUは2スロットを占有し、TDPは600Wで、H200 SXMの700Wより少ないため、INT 8 Tensor Coreの動作が15.6%低下しますが、このGPUはデュアルまたはクアッド構成で900 GB/sのNVLinkインターコネクトをサポートします。H100 NVLと比較して、この新モデルは1.5倍のメモリ、1.2倍の帯域幅、1.7倍のAI推論性能を提供し、HPCアプリケーションの効率が30%向上します。